Eine etalytics-Perspektive auf AI Factories und den „Grid-to-Token“-Betrieb.

Nach NVIDIAs CES-Ankündigung – und invielen Gesprächen mit Kunden und Partnern auf der PTC’26 in Honolulu – kam ein Punkt immer wieder: KI-Rechenzentren bewegen sich in Richtung flüssigkeitsdominanter Kühlung mit Warmwasser-Direktflüssigkeitskühlung (Direct Liquid Cooling, DLC).Entscheidend wird aber nicht sein, wer die „schicksten“ Kreisläufe baut. Entscheidend sind die Standorte, die ihre Regelstrategie am schnellsten anpassen können, wenn sich Rahmenbedingungen ändern.

NVIDIAs Begriff der „AI Factory“ trifft den Wandel gut: Diese Anlagen sind darauf ausgelegt, kontinuierlich Strom, Silizium und Daten in großem Maßstab in „Intelligenz“ zu verwandeln. In dieser Welt ist die Anlage nicht mehr „ein Gebäude mit IT darin“. Damit ist das Rechenzentrum nicht mehr „ein Gebäude mit IT darin“, sondern eine gemeinsam ausgelegte cyber-physische Gesamtmaschine, in der Workload, Energieversorgung und Kühlung permanent zusammenwirken.

Damit verschiebt sich die zentrale Kennzahl von „bestmöglicher Design-Effizienz“ hin zu:

Dauerhafte Rechenleistung pro Kilowatt – unter harten, wechselnden Restriktionen

(Power Caps, thermische Grenzen, Redundanzregeln, Wasserstrategie, Netz- und Grid-Dynamik, Verfügbarkeits-/Uptime-Anforderungen, Ausbaugeschwindigkeit).

Genau deshalb wandert der Wettbewerbsvorteil von der Architektur in den Betrieb:

Die These

Warmwasser-DLC erhöht die Anforderungen – aber Regelungsflexibilität entscheidet, wer den Wert realisiert.

Die besten Betreiber werden keine Setpoints und Sequenzen mehr „von Hand“ nachjustieren. Sie definieren Zielgrößen und Randbedingungen – und die Regelung berechnet laufend den besten zulässigen Betriebspunkt.

Auf Gigawatt-Skala wird die Mathematik gnadenlos: Kleine Prozentverluste kumulieren zu massivem Wertverlust. Wenn eine AI Factory für zweistellige Milliardenbeträge CAPEX steht und über Jahre ein Hochdurchsatz-Umsatzmotor ist, dann ist eine 1%-Lücke bei Tokens-pro-Watt nicht „nice to fix“ – das sind Milliarden.

Darum verlagert sich das Differenzierungsmerkmal von Architektur allein darauf, wie gut man die Anlage dauerhaft am Rand ihrer Grenzen stabil betreibt.

1) Warmwasser-DLC ist ein „Forcing Function“

Warmwasserbasierte, einphasige Direktflüssigkeitskühlung (DLC) hebt die Vorlauftemperaturen an (typisch 30 °C und in Next-Gen-Designs perspektivisch 40–45 °C).

Physikalisch kann das die Wärmeabfuhr in vielen Klimazonen vereinfachen: weniger Chiller-Laufzeit, mehr Freikühlbetrieb (Economizer) und deutlich bessere Optionen für Abwärmenutzung (Heat Reuse).

%20schematic.png)

Operativ passiert aber etwas noch Relevanteres:

Die Betriebsfenster werden enger – und die Kopplung zwischen Teilsystemen nimmt zu. Bei höheren Vorlauftemperaturen zählen Transienten und Stabilität stärker. Der „sichere, effiziente“ Betriebspunkt wird dynamischer, weil er u. a. abhängt von:

- Lastvolatilität (KI-Lastsprünge, synchronisierte Cluster-Shifts)

- Wetterabhängiger Effizienz der Wärmeabfuhr / Rückkühlung

- Anlagenzustand (Fouling, Drift, Teillastverhalten)

- Redundanz-Posture / N+1-Logik und Betriebsmodi

- Verfügbarer Leistung / Netzrestriktionen (Power Caps, Engpässe)

- Abwärmebedarf (wenn Wärme einen Wert bekommt)

Warmwasser verändert also nicht nur die Hardware der Flüssigkeitskühlung. Es verändert, was „guter Betrieb“ in energieeffizienten Rechenzentren überhaupt bedeutet.

2) Die Anlage wird zur Gesamtmaschine – und lokale Regler skalieren nicht

Klassische Kühlungsregelungen (lokale PID-Regler + feste Sequenzen + gelegentliche manuelle Nachjustierung) wurden für stabilere Lasten und langsamere Dynamiken entwickelt.

Was ist in KI-Rechenzentren anders (im Vergleich zu Enterprise-/Colo-Standorten)?

- Synchronisierte, schnelle Lastsprünge: Trainings-/Inference-Cluster können koordiniert hoch- und runterfahren und erzeugen schärfere thermische Transienten als gemischte Enterprise-Workloads.

- Flüssigkeitsdominante Kühlung mit engeren thermischen Envelopes: Direct-to-Chip-Loops und CDUs führen zusätzliche Regel-Ebenen ein; Warmwasser-Strategien reduzieren die „Puffer“ gegen Überschwinger.

- Leistung wird zur aktiven Randbedingung (nicht nur Versorgungsgröße): Power Caps, Power Smoothing und vorgelagerte Power-Management-Strategien verändern das Wärmeprofil, das die Kälteanlage sieht.

- Hohe Auslastung by Design: AI Factories sind auf dauerhaft hohen Durchsatz ausgelegt – weniger „Ruhephasen“, in denen sich die Anlage stabilisiert.

Diese Kombination ist der Grund, warum lokale Regelkreise + starre Sequenzen an Grenzen stoßen: Der optimale Betriebspunkt verschiebt sich schneller, die Margen sind enger, und Instabilität während Lastwechseln wird zur Kernanforderung – nicht zum Sonderfall.

Wenn Regler nicht koordiniert sind, entstehen echte Ausfallmodi – nicht nur Ineffizienz

In einer KI-Kühlanlage können lokale Regelkreise ungewollte Wechselwirkungen erzeugen, die sowohl Energieverbrauch als auch Risiko erhöhen. Ein konkretes Beispiel:

- Die Anlage ist für ein High-Load-/High-Flow-Szenario konfiguriert, deshalb halten die Primärpumpen einen hohen Differenzdruck (Δp), um Worst-Case-Verfügbarkeit sicherzustellen.

- Gleichzeitig ziehen mehrere CDUs auf der Sekundärseite nur einen kleinen Teil ihrer Kapazität (geringe lokale Nachfrage).

- Um ihre lokalen Ziele zu halten, schließen die CDUs (oder Abzweigregler) Regelventile und reduzieren die angeforderte Durchflussmenge.

- Die Primärpumpen drücken gegen ein zunehmend „geschlossenes“ System. Δp steigt, die Pumpe wandert in einen ungünstigen Betriebspunkt, und das System wird unruhig/instabil (Regeljagd, Schwingen).

- Im Worst Case lösen Alarme oder Schutzfunktionen aus: Pumpentrips, Oszillationen oder erzwungene Bypässe – genau dann, wenn thermische Stabilität gebraucht wird.

Kernpunkt: Ohne anlagenweite Koordination kann lokal „korrektes“ Verhalten systemweit Instabilität erzeugen. Betreiber kompensieren dann konservativ: niedrigere Vorlauftemperaturen, höherer Pumpendruck, mehr Trim-Kälte. Das kostet Energieeffizienz (PUE) und reduziert die nutzbare Betriebsreserve – besonders bei Ramps und schnellen Lastwechseln.

3) Was erfolgreiche Betreiber standardisieren: Regelungsarchitektur statt starrer Sequenzen

KI-Standorte werden zwangsläufig heterogener: verschiedene Rack-Generationen, unterschiedliche Chip-Envelopes, verschiedene Standortdesigns, unterschiedliche Pfade für Wärmeabfuhr und Abwärmenutzung. Das Ziel ist aber nicht, für jede Ausnahme eine individuelle Sequenz (oder mechanische „Sonderlösung“) zu bauen. Das Ziel ist das Gegenteil:

So viel Variabilität wie nötig – bei so wenig Komplexität und Kosten wie möglich.

Darum werden die erfolgreichen Betreiber nicht eine einzige starre Sequenz standardisieren und überall kopieren. Sie standardisieren das Regelungs- und Optimierungs-Framework – und lassen die Optimierung innerhalb klar definierter Betriebsgrenzen lokal adaptieren.

Die Gewinner-Logik: Zielgrößen + Randbedingungen, kontinuierlich berechnet

Betreiber wollen nicht für jeden neuen Rack-Typ, jede Netzlimitierung oder jede Abwärmeanforderung Loops nachjustieren. Sie wollen Intent definieren:

- „Halte GPU-Inlet-Temperaturen in diesem Envelope.“

- „Minimiere die gesamte Anlagenleistung (kW), unter Einhaltung der Redundanzregeln.“

- „Vermeide adiabate Kühlung in der Trockenperiode.“

- „Begrenze die Spitzenleistung aufgrund temporärer Grid-Limits.“

- „Wenn Asset X degradiert ist, ändere die Strategie, aber bleibe stabil.“

…und die Regelung berechnet fortlaufend den besten zulässigen Betriebspunkt, damit der Standort Variabilität beherrscht, ohne die operative Komplexität ständig zu erhöhen.

Genau hier wird Flexibilität zum Vorteil: nicht „wir können Warmwasser fahren“, sondern „wir können die Regeln ändern – und trotzdem optimal und stabil fahren, ohne manuelles Tuning“.

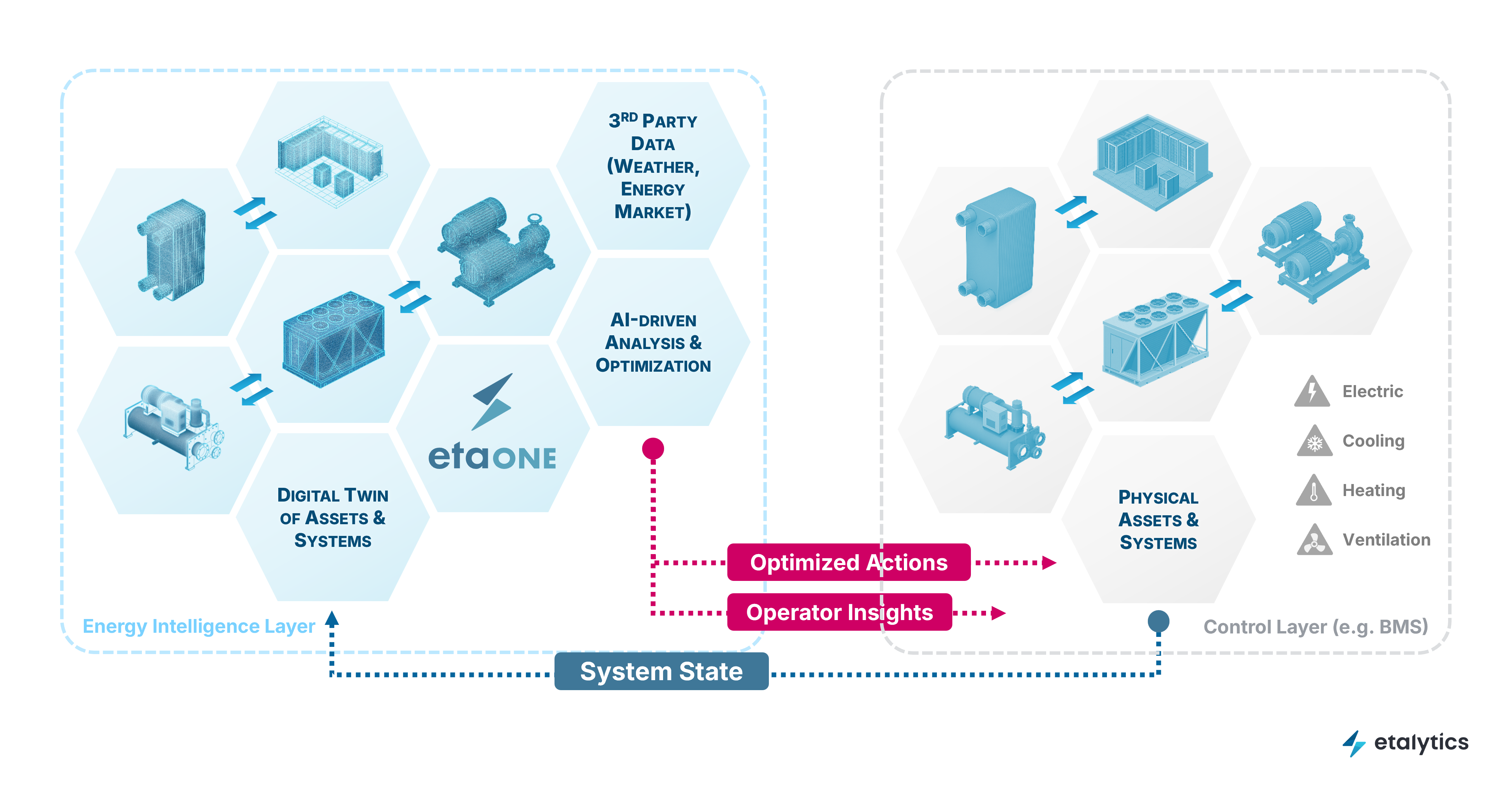

4) Warum der digitale Zwilling zur Betriebsinfrastruktur wird

Sobald Steuerung bedeutet „Optimum unter Randbedingungen berechnen“, braucht man ein Modell des Anlagenverhaltens End-to-End – nicht als Design-Artefakt, sondern als Laufzeit-Werkzeug im Betrieb:

- Interaktionen über Kreisläufe und Aggregate hinweg abbilden

- Trade-offs bewerten (Temperatur, Pumpenergie, Trim-Kälte, Abwärmenutzung, Wasser, Power Caps)

- schnelle „What-if“-Änderungen unterstützen (neuer Rack-Typ, neue Restriktion, Ausfall/Downtime)

- sichere Iteration ermöglichen: Änderungen validieren, bevor sie in die Produktion gehen

Hier wird „Digitaler Zwilling + Optimierung“ zur Voraussetzung – nicht weil es „trendy“ ist, sondern weil es der einzige praktikable Weg ist, näher an den Grenzen zu fahren, während sich Constraints täglich ändern.

Bei etalytics ist das der Kern der Perspektive: Die besten Standorte fühlen sich im Betrieb nicht komplexer an – weil Kontrolle/Regelung durch KI- und Digital-Twin-getriebene Software übernommen wird.

5) Eine praktische Betreiber-Checkliste

Control Readiness für warmwasserbasierte, flüssigkeitsdominante KI-Rechenzentren

1. Transparenz / Messbarkeit (Observability)

▢ zuverlässige Vor-/Rücklauftemperaturen, Durchflüsse, Differenzdruck (pro Loop)

▢ End-to-End-Messung thermischer und elektrischer Flüsse

▢ Health-Signale (Approach-Temp-Drift, Fouling-Indikatoren, Aktor-/Ventilperformance)

2. Stellbarkeit (Actuation)

▢ drehzahlvariable Pumpen dort, wo es wirklich zählt

▢ Ventile, die Durchfluss vorhersehbar formen (nicht nur Auf/Zu-Logik)

▢ effiziente Stufung/Regelung der Wärmeabfuhr bei Teillast

3. Klare Trennung von Safety und Optimierung

▢ deterministische Sicherheitslogik (Hard Limits, Fallback-Modi)

▢ Optimierung darf innerhalb definierter Betriebsgrenzen operieren

4. Operativer digitaler Zwilling

▢ schnelle „Was-wäre-wenn“-Fähigkeit

▢ häufige Setpoint-Neuberechnung

▢ Nachvollziehbarkeit/Auditierbarkeit: was wurde geändert, warum, und welche Bounds/Constraints galten

Schluss: Der smartere Kreislauf gewinnt

Warmwasser-DLC ist ein technischer Meilenstein – aber auch ein strategischer „Forcing Function“. Er macht sichtbar, worum es im Betrieb wirklich geht.

Das Differenzierungsmerkmal ist nicht der kältere Kreislauf oder eine neue CDU.

Es ist Regelungsflexibilität: Ziele und Randbedingungen schnell anpassen zu können – und dabei stabil zu bleiben, ohne menschliches Nachregeln.

Die Standorte, die gewinnen, werden diejenigen sein, die:

- die Anlage End-to-End mit einem operativen digitalen Zwilling modellieren,

- über Ziele und Constraints (statt statischer Sequenzen) betreiben,

- thermische und elektrische Realität (Power, Grid, Kühlung) koordiniert betrachten,

- Setpoints kontinuierlich aktualisieren – autonom, aber governable.

Das ist „Next-Level Cooling“ im Zeitalter der AI Factory: ein smarterer Kreislauf, der unter Veränderung stabil bleibt.

In der Praxis sehen Betreiber häufig zweistellige Reduktionen der Kühlenergie. Unter den richtigen Baselines und Systemgrenzen können die Ergebnisse deutlich höher ausfallen.

Neugierig, was Regelungsflexibilität in Ihrer Anlage freisetzen würde?

Sprechen Sie etalytics an – wir machen ein Quick Assessment: Ihre bindenden Constraints (thermisch / Power / Wasser), Ihre verfügbaren Setpoint-Freiheitsgrade und welche Einsparungen sowie Stabilitätsgewinne realistisch sind.